Nauka

Przebadano pół miliona ludzi. Jeden wniosek: wsiadaj na rower

29 czerwca 2025

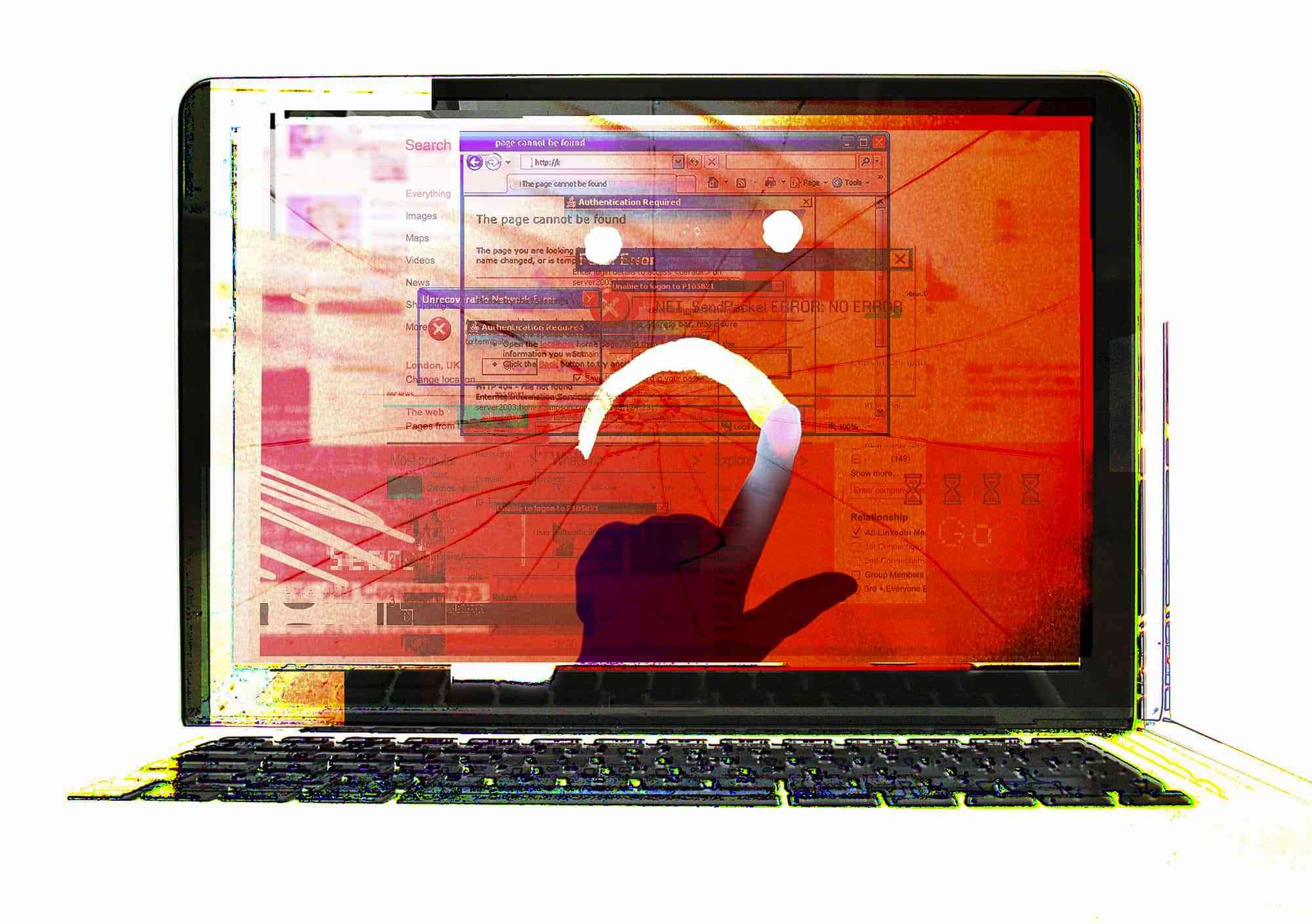

W internecie coraz większą popularność zyskuje nowa forma dezinformacji – deep fakes. Eksperci ostrzegają, że nie tylko niszczy ona reputację osób publicznych, ale może poważnie zagrażać demokracji. Ich ofiarą może paść każdy, a walka z tym zjawiskiem jest niezwykle trudna.

Jeśli ktokolwiek widział wideo krążące w sieci, w którym Donald Trump z twarzą Nicolasa Cage’a obraża samego siebie i proponuje pomoc finansową migrantom z Bliskiego Wschodu, to znaczy, że trafił na najnowszy dezinformacyjny wytwór – deep fakes. Eksperci ostrzegają, że jest to jedno z najnowszych i najbardziej niebezpiecznych zjawisk w dziedzinie dezinformacji.

Deep fakes („głęboki fałsz”) to fałszywe treści funkcjonujące w internecie w formie zmanipulowanych form wideo. Filmowa odmiana fake newsa jest wykorzystywana do niszczenia reputacji znanych osób oraz tworzenia alternatywnej rzeczywistości zaprzeczającej realnym wydarzeniom, o których informują wiarygodne źródła.

Deep fakes powstają przy pomocy coraz bardziej skomplikowanych algorytmów, które potrafią samodzielnie tworzyć zmanipulowany obraz wideo. Dzięki rozwojowi sztucznej inteligencji filmy tego rodzaju są coraz bardziej realistyczne i trudniejsze do wychwycenia w sieci.

Pomysł produkowania deep fakes narodził się wśród użytkowników amerykańskiego portalu Reddit.com. Okazało się, że w tej zbiorowości funkcjonowało wielu informatyków o niespełnionych fantazjach filmowca-amatora. Jeden z pierwszych programistów, który zaczął tworzyć zmanipulowane filmy za pomocą wcześniej napisanego algorytmu, działał w sieci pod nickiem „deepfakes”. Tworzył głównie filmy porno, w których umieszczał twarze celebrytów. Błyskawicznie znalazł naśladowców, których wytwory zaczęto nazywać właśnie deep fakes.

Aktualnie w sieci dominują dwa typy „głębokiego fałszu”. Pierwszy to wideo imitujące filmy pornograficzne. Bohaterom takiej produkcji specjalnie napisany do tego program „nakłada” twarze celebrytów. Ofiarami takiej „twórczości” padły m. in. Scarlett Johansson, Emma Watson, Daisy Ridley, a także gwiazdy „Gry o tron” – Sophie Turner i Maisie Williams. Jednym z najgłośniejszych przykładów deep fakes w stylu porno było wideo z aktorką Gal Gadot, które w ubiegłym roku opanowało media społecznościowe.

Ten typ deep fakes powstaje m.in. dzięki inteligentnemu algorytmowi z kategorii Generative Adversarial Networks (GANs), który potrafi sam nauczyć się cech dystynktywnych konkretnej postaci (mimiki, tonu głosu itd.), a następnie zsynchronizować je z resztą materiału tak, by efekt końcowy wydawał się jak najbardziej wiarygodny. Z oryginalnego filmu pornograficznego znikają zatem twarze aktorów, a w ich miejsce pojawiają się inne.

Drugi rodzaj deep fakes to filmy kompromitujące polityków. Postaciom podmienia się zazwyczaj twarz lub usta i podkłada głos wypowiadający treści ośmieszające zarówno ich „autora”, jak i przeciwników politycznych. Ten typ dezinformacji może być jednym z najpopularniejszych podczas przyszłych kampanii wyborczych.

Poniżej przykład deep fake z udziałem Baracka Obamy, który stworzyła redakcja BuzzFeed na potrzeby eksperymentu. W wideo Obama rzekomo obraża swojego następcę – Donalda Trumpa.

Z kolei w tym wideo widzimy, w jaki sposób program komputerowy tworzy zmanipulowany film.

Ofiarą deep fakes może de facto być każdy, kto upublicznia swój wizerunek w internecie. To jedna z najbardziej upokarzających form dezinformacji.

W niedalekiej przyszłości technologia deep fakes – wraz z udoskonalaniem algorytmów – może stanowić zagrożenie globalne. „Nie jesteśmy jeszcze na etapie, w którym tego typu filmy mogą zostać wykorzystane jako broń, ale ten moment już nadchodzi” – uważa profesor Uniwersytetu Teksańskiego Robert Chesney.

W środowisku naukowym pojawiają się obawy o cele, do jakich mogą być wykorzystane zmanipulowane materiały wideo. Naukowcy prognozują, że takie filmy staną się narzędziem hakerów, szczególnie w rozgrywkach politycznych i biznesowych. Nie znikną również z show-biznesu.

Zdaniem Paula Scharre’a, eksperta amerykańskiego think tanku Center for a New American Security (CNAS), specjalizującego się w tematyce sztucznej inteligencji, kolejne kampanie wyborcze w Stanach Zjednoczonych upłyną właśnie pod znakiem deep fakes wyrządzających poważne szkody społeczne.

Specjaliści podkreślają, że trudno walczyć z narastającym zagrożeniem, jeśli giganci technologiczni, m.in. Google, udostępniają anonimowym internautom – często za darmo – narzędzia oraz algorytmy umożliwiające tworzenie zmanipulowanych filmów. W ich pracach można zauważyć niedoskonałości i potknięcia, ale niektórzy zaczynają niebezpiecznie zbliżać się do perfekcji.

W odpowiedzi na poważne zagrożenia, jakie mogą wynikać z szybkiego rozwoju deep fakes, proponowane są konkretne działania, głównie w Stanach Zjednoczonych, które są największym na świecie siedliskiem zmanipulowanych treści wideo.

Amerykański Departament Obrony opracował już pierwsze narzędzia do ich wykrywania. W pierwotnych materiałach było to znacznie prostsze, ponieważ postacie nie mrugały albo robiły to bardzo nienaturalnie. Ten istotny szczegół mógł wykryć prosty komputerowy algorytm. Najnowsze generacje deep fakes są coraz bardziej wyrafinowane, a ich wykrywanie wymaga stosowania nowych rozwiązań. Zadaniem specjalnych algorytmów-wykrywaczy jest przeszukiwanie internetu w celu znalezienia oryginalnego zdjęcia lub filmu wykorzystanych w zmanipulowanym materiale, a następnie porównywanie ich z podejrzanym plikiem. W toku analizy sprawdza się m. in., czy kąt padania światła oraz cienie obiektów są zgodne z prawami fizyki.

Zdaniem Paula Scharre’a, aktualnie mamy do czynienia z „wyścigiem zbrojeń” między tymi, którzy tworzą zmanipulowane filmy oraz ekspertami w dziedzinie bezpieczeństwa dążącymi do opracowania skutecznych narzędzi wykrywających treści wideo tego typu. Najbardziej efektywnym sposobem walki z deep fakes wydaje się być zwiększenie świadomości społecznej w kwestii ochrony prywatności w sieci.

Źródła: Focus.pl, Mediaphilia.pl