Nauka

Szokujące lekarstwa Rzymian. Co nimi leczono?

09 marca 2026

Zaproponowanie nowej umowy społecznej dla cyfrowego świata to niebagatelna praca. Pojawiły się już jednak pierwsze pomysły, które mogą stać się podstawą nowego „ładu”. Jak będzie wyglądać nowy model funkcjonowania internetu?

W Brukseli nikogo nie trzeba już przekonywać, że potrzebny jest nowy pomysł na urządzenie internetu. Pomysł, który pogodzi trudne do pogodzenia potrzeby. Po pierwsze, firm chcących wciąż zarabiać na naszej uwadze i naszych danych, bo przez ostatnie dwie dekady mogły to robić bez konsekwencji. Po drugie, użytkowników, którzy już mają dość bycia towarem, ale jeszcze nie (wszyscy) są skłonni płacić za bezpieczne i etyczne usługi. Po trzecie, państwa starającego się odzyskać kontrolę nad siecią. Internet stał się najważniejszą infrastrukturą komunikacyjną, ale przecież państwo nie może tak po prostu „wywłaszczyć” prywatnych korporacji.

Potrzebujemy pomysłu na cyfrową umowę społeczną, która na nowo ułoży relacje władzy. To znaczy zdefiniuje cele rozwoju technologicznego; w bardziej uczciwy, zrównoważony sposób podzieli zarówno wynikające z tego rozwoju korzyści, jak i odpowiedzialność za jej społeczne koszty. Sformułowanie takiej umowy nie jest łatwe, ale staje się coraz pilniejsze.

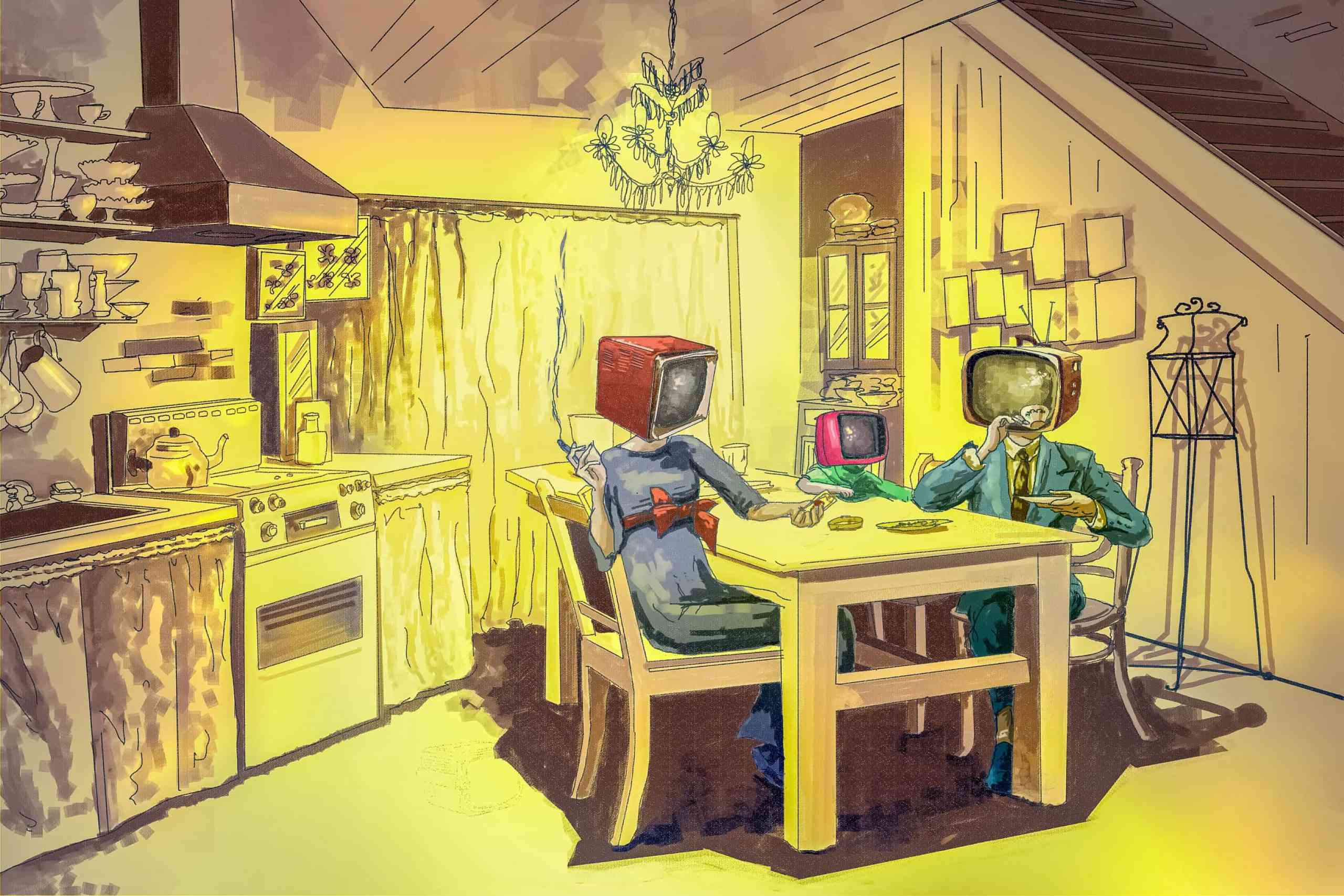

Rysująca się na politycznym horyzoncie zmiana oznacza przestawienie dobrze naoliwionej maszyny do robienia pieniędzy na inne tory. Obecnie ludzie są tylko „użytkownikami” – skazanymi na płacenie za usługi swoimi danymi – obserwowanymi i stymulowanymi po to, by nie przestawali konsumować. Natomiast świat powinien dążyć do modelu, w którym dane są wykorzystywane przez nas i dla naszego dobra, np. do rozwiązywania społecznych problemów. To podobne wyzwanie, takie jak przestawienie gospodarki rynkowej, przez dekady nastawionej na wzrost produkcji, na funkcjonowanie w warunkach kryzysu ekologicznego, który wymaga radykalnego ograniczenia potrzeb.

Powoli oswajamy słowa i koncepcje, które jeszcze dziesięć lat temu mogły brzmieć radykalnie, takie jak „spowolnienie” i „ograniczenie”. Przez co przestajemy kreować sztuczne, indywidualne potrzeby na rzecz rozwiązywania realnych problemów społecznych. Europa w 2020 r. wraca do swoich socjaldemokratycznych korzeni i rozstaje się z liberalnymi dogmatami.

Nie bez powodu te dogmaty trzymają się najmocniej w dyskusji o nowych technologiach. Łatwiej się zgodzić, że koncerny paliwowe powinny ponosić odpowiedzialność za negatywne skutki społeczne swoich działań, niż powiedzieć to samo w odniesieniu do sympatycznych internetowych usługodawców. A jednak to jest to samo. Jedyna różnica polega na tym, że na temat szkodliwych skutków wydobywania i spalania paliw wiemy już bardzo dużo, a społeczne skutki gospodarki opartej na eksploatacji danych dopiero rozpoznajemy. Przy czym ich niematerialna i globalna natura czyni to rozpoznanie trudniejszym.

Dla przykładu: doświadczamy dezinformacji, ale jeszcze nie całkiem rozumiemy, skąd biorą się jej skala i siła rażenia. Niepokoją nas uzależniające modele konsumowania treści, ale jeszcze nie łączymy ich z modelem biznesowym internetowych mediów. Przeżywamy dystopijne narracje, kreowane przez twórców Black Mirror, ale jeszcze nie łączymy ich z własnym doświadczeniem – z oceną, którą codziennie wystawiają nam Facebook, Uber albo nasz internetowy bank.

Komisja Europejska już powiedziała pierwsze zdanie: Kodeks usług cyfrowych (Digital Services Act). To robocza nazwa pakietu regulacyjnego, którego celem są przede wszystkim globalne technologiczne platformy. To więcej niż oczekiwana od dawna rewizja dyrektywy o handlu elektronicznym, która na parę dekad ustaliła zasady odpowiedzialności pośredników internetowych za publikowane treści. Wówczas przyjęliśmy, że platformy są tylko neutralnymi pośrednikami. Dziś musimy porozmawiać o ich odpowiedzialności za to, w jaki sposób moderują, filtrują i cenzurują cyfrowe treści. Ale to nie koniec, bo ta rozmowa nie może się kończyć na prawach użytkowników. Kodeks usług cyfrowych ma być też odpowiedzią na negatywne społeczne skutki modelu biznesowego, który wypromowały firmy z Doliny Krzemowej.

W pierwszych założeniach, które konsultują państwa członkowskie, pojawiły się m.in. pytania o to, co zrobić z reklamą polityczną i problemem dezinformacji: czy platformy internetowe powinny czyścić sieć także z botów, fake newsów i propagandy?; jak zarządzać prywatną infrastrukturą, która stała się kluczowa dla debaty publicznej i całej komunikacji społecznej?

Europejscy urzędnicy nie mają na nie gotowych odpowiedzi. Zapowiadają, że projekt konkretnych rozwiązań pojawi się pod koniec tego roku. Dają sobie i nam chwilę, żeby te rozwiązania przemyśleć i przedyskutować. W tej dyskusji na pewno odezwą się bezpośrednio zainteresowani, czyli firmy z Doliny Krzemowej. One będą walczyć o zachowanie takiego układu sił, w którym państwa nie narzucałyby im twardych ograniczeń, ale w coraz większym stopniu polegałyby na ich zasobach i pomysłach, jak radzić sobie z cyfrowymi wyzwaniami.

To niebezpieczne i krótkowzroczne podejście. Przez ostatnią dekadę zdążyliśmy się przekonać, że prywatne korporacje w roli arbitrów etycznych, sędziów i policjantów nie sprawdzają się dobrze. Co więcej, trudno je winić, że w tej politycznej układance dbają przede wszystkim o własne interesy. Tak jak trudno się dziwić, że wykorzystują wiedzę o ludziach, którą zgromadziły przez lata, do maksymalizowania zarobków, a nie po to, by rozwiązywać nasze problemy. Jeśli chcemy zadbać o własne interesy, sami musimy wejść do gry.

Zaproponowanie nowej umowy społecznej dla cyfrowego świata to niebagatelna praca. Praca, która nie może się wydarzyć w jednym ośrodku władzy i potrwa zdecydowanie dłużej niż rok. Koniec 2020 r. i propozycja, jaką położy na stole Komisja Europejska, będzie zatem czymś w rodzaju otwarcia negocjacji. Konkretne rozwiązania najpewniej będą się ucierać gdzieś między Waszyngtonem, Brukselą, Londynem i Pekinem.

Globalnych graczy może zaskoczyć nasz głos. O czym powinniśmy rozmawiać, żeby przesunąć granicę „możliwego” w dobrym kierunku? Jakie zasady i wartości mogą zastąpić stare, liberalne dogmaty? Oto kilka pomysłów, które już zyskały popularność w europejskich kręgach i mają szansę zakorzenić się w nowej regulacji:

Platformy internetowe nie publikują własnych treści. Ich model biznesowy zakłada łączenie autorów i odbiorców treści lub usług. Bycie pomiędzy. Dlatego słusznie jest założenie, że nie powinny odpowiadać za każdą bezprawną treść czy każde działanie swoich użytkowników. To jednak wcale nie oznacza, że powinny być zwolnione z odpowiedzialności za działania swoich pracowników i algorytmów: moderowanie, cenzurowanie, filtrowanie i dopasowywanie treści. Za wszystko to, co robią, by zarobić na swoich użytkownikach lub zaoferować im lepsze doświadczenie. Po prostu, platformy internetowe muszą, jak każda inna firma, odpowiadać – przed nami i przed prawem za to, jaki obraz świata i jakie doświadczenie nam serwują.

Technologia nie rozwija się sama. Możemy stawiać jej wymagania i ograniczenia. Nie jesteśmy skazani na władzę „sztucznej inteligencji” (cokolwiek ten termin oznacza) samodzielnie decydującej nie tylko o tym, jakie zobaczymy reklamy, lecz także jaką dostaniemy ofertę kredytu albo czy nasze CV przejdzie proces rekrutacyjny. Możemy i powinniśmy wymagać, by automatyczne decyzje, które wpływają na życie ludzi, były możliwe do rozliczenia. Twórcy tego typu rozwiązań dokonują świadomych wyborów: czy postawić na model łatwy do zinterpretowania czy nieprzejrzysty?; czy nadzorować uczenie maszynowe, czy zaryzykować i „puścić je wolno”?; czy zainwestować w narzędzia testujące i sprawdzające działanie systemu, czy od razu powiedzieć „nie da się” albo „sami nie wiemy, jak to działa”. Wytyczne brytyjskiego organu ds. ochronny danych osobowych, opracowane we współpracy z renomowanym Instytutem Alana Turinga, nie pozostawiają wątpliwości: „Da się!”. Nawet technologiczną czarną skrzynkę da się otworzyć, a przynajmniej sprawdzić zasadę jej działania.

Skoro już jesteśmy przy targetowaniu, trzeba powiedzieć, że reklama to forma perswazji, która w konkretnych okolicznościach może być niebezpieczna. Może manipulować naszymi potrzebami, wpływać na naszą samoocenę, wykorzystywać silne emocje i często właśnie to robi. Także zdarza się, choć to niezgodne z prawem, że jest kierowana do dzieci.

Nie musimy tego tolerować. Unia Europejska wiele razy już zabierała się do regulowania reklamy i może zrobić to ponownie. Nie tylko reklamy politycznej, która od paru lat jest na celowniku, ale każdej, która na cel bierze człowieka i jego słabości.

Model biznesowy internetowych korporacji, w którym człowiek i jego dane stały się towarem, wyrządził wiele szkody, ale też wygenerował nową wartość: wiedzę. Pochodzi ona z obserwacji miliardów ludzi i porównywania ich zachowań. Tak zwane wielkie dane (big data) to nic innego jak nowa nauka o ludziach oparta na analizie statystycznej. Użyta do przewidywania zachowań konkretnych osób nie zawsze się sprawdza. Użyta po to, by wpłynąć na działanie konkretnej osoby, bywa niebezpieczna. Takie ryzykowne zastosowania big data muszą być poddane kontroli, i to nie tylko kontroli niezależnego organu (np. Urzędu Ochrony Danych Osobowych), lecz także kontroli każdego użytkownika (np. w ustawieniach prywatności).

Z drugiej strony, cała ta wiedza o ludziach nie powinna służyć wyłącznie do generowania zysku. Dlaczego nie miałaby być wykorzystana do analizy trendów, badań społecznych i projektowania polityk publicznych przez tych, którzy reprezentują nasze interesy? Unia Europejska powinna otworzyć dostęp do komercyjnej wiedzy tym podmiotom, które działają w interesie społecznym.

To nieprawda, że ludziom nie zależy na prywatności. Prowadzone regularnie badania (m.in. Eurobarometr) potwierdzają, że chcemy mieć kontrolę nad swoimi danymi. Ale przecież nie chcemy spędzać połowy czasu w sieci, klikając w wyskakujące okienka, przeglądając ustawienia prywatności i frustrując się, że nie ma w nich prostego przycisku „Nie śledź mnie!”. Przerzucenie odpowiedzialności za pilnowanie własnych danych na osamotnionego użytkownika to nie jest rozwiązane. Najgorsze praktyki firm są i będą ścigane na gruncie RODO, ale żaden urząd nie skontroluje wszystkich. W tej grze potrzebujemy kogoś, kto będzie miał realny interes w tym, by dbać o nasze interesy. Zaufanej trzeciej strony, która – działając na nasze zlecenie – będzie mogła sprawdzić, co tak naprawdę dzieje się z naszymi danymi.

Ten nowy model biznesowy już się narodził. Unia Europejska musi jedynie zadbać o to, by nasz cyfrowy asystent miał się do czego podłączyć, kiedy zapuka do Facebooka albo Google’a.

Dziękujemy, że przyczytałeś artykuł do końca. Jesli chcesz, możesz wesprzeć naszą pracę: