Prawda i Dobro

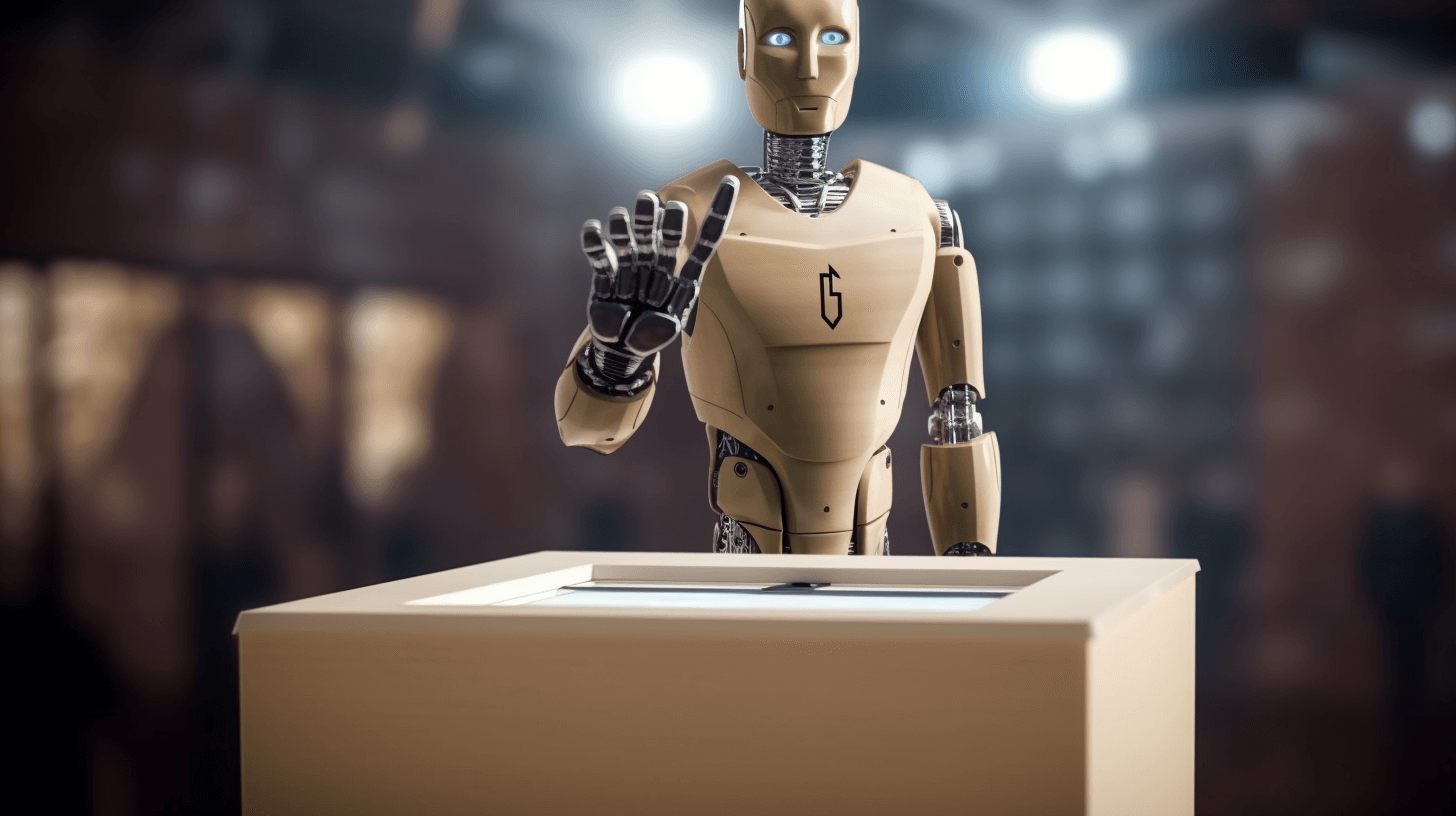

Chatboty zagrażają demokracji? Zbadano poglądy polityczne AI

10 marca 2026

Naukowcy z Brigham Young University (BYU) przeprowadzili eksperyment mający na celu określenie, czy sztucznej inteligencji (SI) można użyć jako zamiennika ludzkich respondentów w badaniach ankietowych. Aby przetestować skuteczność algorytmów, w studium użyto modelu językowego GPT-3, który imituje ludzkie idee, postawy i konteksty społeczno-kulturowe.

W ramach tego doświadczenia utworzono sztuczne persony z przypisanymi cechami, takimi jak rasa, wiek, światopogląd i wyznanie, a następnie porównano ich wzorce głosowania w poprzednich wyborach prezydenckich w USA z tymi osób rzeczywistych. Co ciekawe, analiza wykazała wysoką zgodność między głosowaniem sztucznych person SI a ludźmi, mimo że model SI nie był specjalnie szkolony w dziedzinie nauk politycznych.

W kolejnym eksperymencie naukowcy przeprowadzili szczegółowe badania mające na celu sprawdzenie, jak realistyczne mogą być odpowiedzi generowane przez sztuczną inteligencję w kontekście sondaży. W tym celu sztuczne persony SI, zostały poddane warunkowaniu w taki sposób, aby udzielały odpowiedzi z listy opcji w ankietach przeprowadzanych w formie wywiadu. Wzorce odpowiedzi generowanych przez te sztuczne persony ponownie przypominały ludzkie.

To odkrycie ma ogromne znaczenie dla przyszłości badań ankietowych, ponieważ otwiera nowe możliwości wykorzystania sztucznej inteligencji w tym obszarze. Jeśli SI może generować realistyczne odpowiedzi, to eksperci mogą skorzystać z tej technologii, aby uzyskać szerszy i bardziej różnorodny wgląd w opinie i preferencje społeczeństwa.

Dodatkowo, realistyczne odpowiedzi generowane przez SI mogą pomóc w analizie grup trudno dostępnych. Przykłady takich grup obejmują uchodźców, migrantów, mniejszości etniczne, osoby z niepełnosprawnościami oraz ludzi w podeszłym wieku.

Jeśli chcemy zbadać preferencje i opinie osób, które są trudno osiągalne lub niechętnie uczestniczą w tradycyjnych ankietach, sztuczna inteligencja może symulować ich odpowiedzi, dając nam cenne informacje na temat tych grup.

Przeczytaj także:

Mimo obiecujących wyników specjaliści podkreślają, że SI nie powinna zastępować analizy ludzi. Istnieją ograniczenia, które warto brać pod uwagę. Przede wszystkim, sztuczna inteligencja korzysta z faktycznych danych, co może prowadzić do uwidocznienia uprzedzeń oraz nierówności społecznych. Użycie modelu SI do badania opinii publicznej, może prowadzić do zniekształcenia wyników lub ich nieodpowiedniej reprezentatywności.

Warto także pamiętać, że nieuczciwi użytkownicy mogą próbować manipulować sztuczną inteligencją w celu osiągnięcia prywatnych korzyści lub celowego rozpowszechniania dezinformacji. Na przykład, są w stanie tworzyć fałszywe konta lub generować nieprawdziwe odpowiedzi w celu wpływania na wyniki sondaży. Takie manipulacje mają szansę wprowadzać błędne wyniki i prowadzić do mylnych wniosków. Dlatego ważne jest, aby opracować odpowiednie procedury kontroli i weryfikacji wyników badaniach ankietowych uzyskanych przy użyciu sztucznej inteligencji. Ponadto istotne jest jasne określenie i przestrzeganie etycznych granic, aby zagwarantować uczciwość i wiarygodność tego rodzaju ekspertyz.

Zobacz też:

Przyszłość sztucznej inteligencji (SI) w badaniach ankietowych wydaje się niezwykle obiecująca. Obecnie używane modele SI, takie jak GPT-4, to tylko początek możliwości dużych modeli językowych. W miarę dalszego rozwoju i ewolucji modeli SI możemy spodziewać się bardziej precyzyjnych i autentycznych symulacji zachowań ludzkich w różnych kontekstach.

Analiza przeprowadzona na BYU dostarcza istotnych kryteriów dla przyszłych badaczy, aby ocenić dokładność modeli SI w różnych dziedzinach nauki. Przewiduje się, że sztuczna inteligencja przyniesie społeczeństwu zarówno korzyści, jak i negatywne konsekwencje, a jej możliwości będą się dalej rozwijać. Warto zatem zwracać uwagę na rozwój tych mechanizmów i równocześnie podejmować odpowiednie środki, aby korzystać z nich w sposób odpowiedzialny i użyteczny dla społeczeństwa.

Może cię również zainteresować:

Więcej na www.holistic.news

Dziękujemy, że przyczytałeś artykuł do końca. Jesli chcesz, możesz wesprzeć naszą pracę: