Humanizm

Metoda FUKO. Prosty sposób, żeby poprawić komunikację w pracy

01 lipca 2025

Google zaprezentowało nową metodę walki z uprzedzeniami, których sztuczna inteligencja uczy się od ludzi. Z powodu cyfrowej dyskryminacji poważne kłopoty mają m.in. kobiety

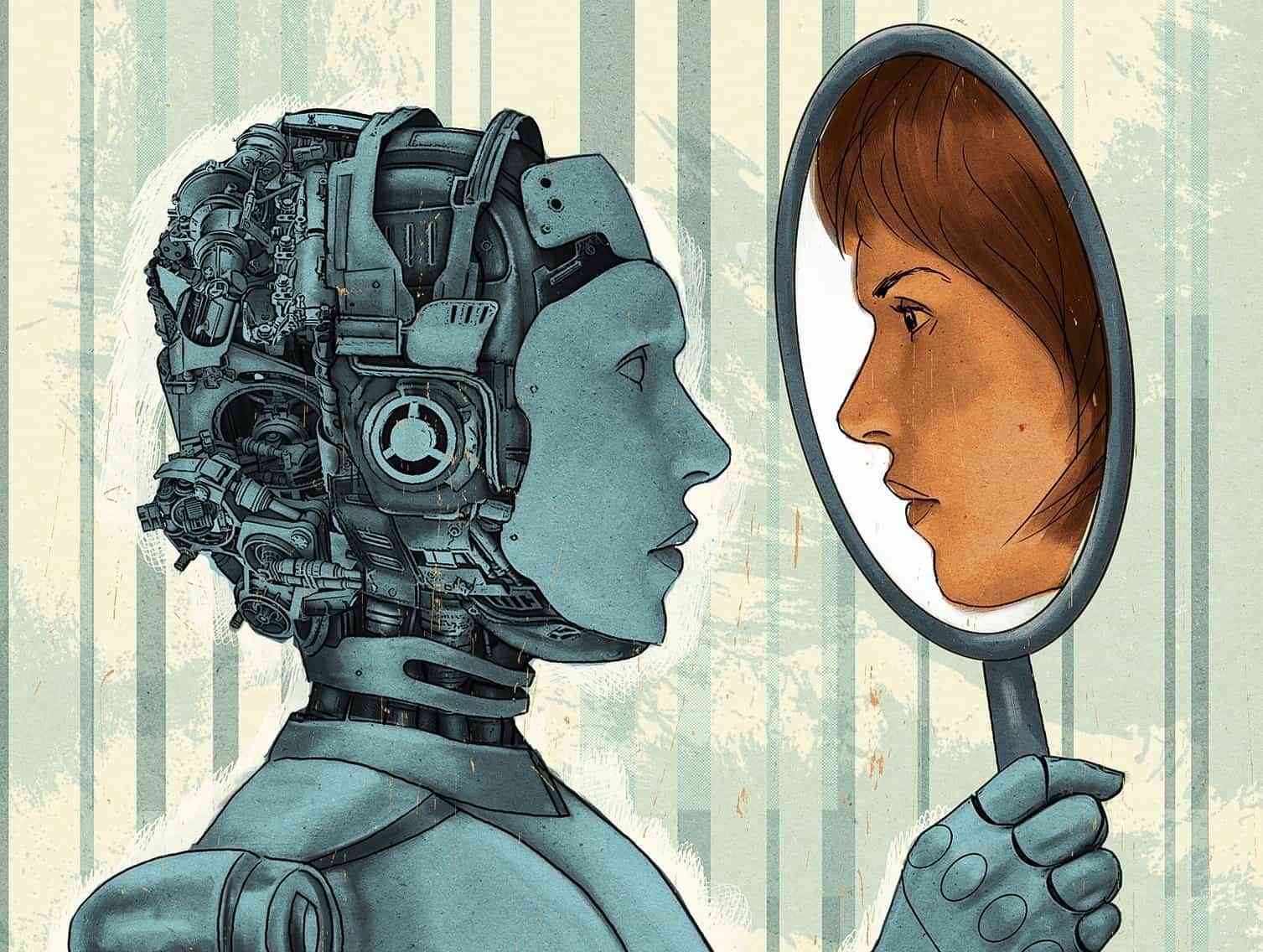

Sztuczna inteligencja jest ograniczonym odbiciem ludzkiego umysłu, wraz z jego zaletami i wadami. Programiści podkreślają, że próbując naśladować lub zastąpić człowieka przy wyznaczonych jej zadaniach, kopiuje od nas także złe nawyki. Cyfrowo „dziedziczy” skłonność do dyskryminowania mniejszości, szowinizmu czy rasizmu.

W maju 2016 r. amerykańska organizacja ProPublica zrzeszająca dziennikarzy śledczych przedstawiła kontrowersyjny raport, który dowodził, że program komputerowy wykorzystywany w sądach Stanów Zjednoczonych dyskryminuje czarnoskórych mężczyzn. Correctional Offender Management Profiling for Alternative Sanctions (Compas) pomagał wymiarowi sprawiedliwości obliczać sankcje i wskazywać osoby skłonne do ponownego naruszenia prawa. Jak dowiedli dziennikarze, program typował czarnoskórych mężczyzn dwa razy częściej niż białych.

Podobny problem miał Amazon. W październiku 2018 r. agencja Reutera podała informację o konieczności wycofania programu stosowanego przez koncern do cyfrowej rekrutacji. Okazało się, że sztuczna inteligencja preferowała męskich kandydatów na stanowiska. System nauczył się dyskryminacji kobiet, gdyż do jego tworzenia wykorzystano dane tworzone głównie przez mężczyzn.

Z dyskryminującą sztuczną inteligencją chce walczyć amerykański gigant technologiczny Google. „Algorytmy nie powinny utrwalać stereotypów” – powiedział prezes Google Sundar Pichai podczas corocznej konferencji deweloperskiej. Wydarzenie wykorzystał do ogłoszenia przełomu w tej dziedzinie.

Odpowiedzią na zdarzające się praktyki dyskryminacyjne ma być nowa metoda nazwana TCAV, która nauczy algorytmy rozpoznawania niepokojących ludzkich zachowań. Pozwoli ona wskazać elementy, które najczęściej przyczyniają się do powstawania mechanizmów dyskryminujących w zautomatyzowanych procesach decyzyjnych algorytmów.

W praktyce oznacza to, że jeśli algorytm otrzyma zadanie wskazania osoby wykonującej zawód lekarza wśród kilku tysięcy zdjęć przedstawiających ludzi, to nadzorujący jego pracę programista zostanie zaalarmowany, gdy sztuczna inteligencja zacznie kierować się kolorem skóry, płcią lub wiekiem osób na zdjęciach.

Jak informuje portal Digital Information World, przy pomocy TCAV algorytmy będą w stanie analizować i wykrywać dyskryminację, jednak nie rozwiążą problemu, ponieważ nie będą zdolne do jej usunięcia. Za skorygowanie działania sztucznej inteligencji będą odpowiedzialni jej twórcy, tacy jak np. Google. „To ważny krok w kierunku postępu, jeśli zostanie właściwie zastosowany” – czytamy w portalu.

Twórcy TCAV nie ukrywają, że potrzeba znacznie więcej wysiłków, by przezwyciężyć potencjalne uprzedzenia sztucznej inteligencji, ponieważ coraz częściej korzystają z niej organy państwa, np. wydziały policji i sądy.

Źródła: Reuter, BBC, Digital Information World, Google, Guardian