Nauka

Miłość wyłącza hamulce. I to nie tylko te emocjonalne

23 lutego 2026

Popularne duże modele językowe (ang. Large Language Models), takie jak ChatGPT czy Bard Google wymagają wydajnych serwerów o ogromnej mocy obliczeniowej. Linguaboty AI potrzebują dużych ilości cieczy do chłodzenia, co zaczyna być poważnym problemem. Nowe badania sugerują, że trening GPT-3 pochłonął 700 000 litrów chłodziwa. Biorąc pod uwagę popularność chatbota, naukowcy obawiają się, że może mieć to niepokojący wpływ na zasoby wody na Ziemi.

Naukowcy z Uniwersytetu Riverside w Kalifornii i Uniwersytetu Arlington w Teksasie opublikowali artykuł, w którym szacują, ile wody potrzeba do chłodzenia serwerów obsługujących sztuczną inteligencję. Autorzy stwierdzili, że wyszkolenie GPT-3 wiązało się ze użyciem takiej ilości cieczy, jakiej potrzeba do wypełnienia wieży chłodniczej reaktora jądrowego.

Badacze obliczyli, że samo szkolenie ChatGPT-3 może zużywać 700 000 litrów słodkiej wody rocznie, co odpowiada ilości potrzebnej do wyprodukowania 370 samochodów BMW lub 320 pojazdów elektrycznych Tesla. Gdyby trenowanie odbywało się w azjatyckich centrach danych firmy OpenAI, zużycie wody wzrosłoby trzykrotnie.

Zobacz również:

Podczas każdej sesji z ChatGPT, składającej się z około 20–50 pytań i odpowiedzi, linguabot potrzebuje 500 ml czynnika chłodniczego. To może wydawać się niewiele. Trzeba jednak wziąć pod uwagę, że narzędzie to było oprogramowaniem, które osiągnęło, zgromadziło milion użytkowników w najkrótszym czasie. Obecnie ma ich ponad 100 milionów, więc całkowita ilość zużywanej cieczy jest wystarczająca, aby wzbudzić niepokój.

Naukowcy spodziewają się, że zapotrzebowanie na wodę wzrośnie jeszcze bardziej w przypadku nowszych modeli, takich jak niedawno wydany GPT-4. Opierają się one bowiem na większym zestawie danych niż poprzednie wersje linguabota.

Zużycie wody przez modele AI nie może dłużej pozostawać poza kontrolą. Trzeba to traktować priorytetowo w ramach wspólnych wysiłków na rzecz zwalczania globalnych wyzwań związanych z ochroną zasobów wody

napisali amerykańscy badacze w swoim artykule.

W roku 2022 Microsoft zanotował wzrost wykorzystania cieczy o 34 procent w porównaniu do roku 2021, osiągając niemal 6,4 miliarda litrów. W tym samym okresie Google zwiększył zużycie o 20 procent. Jeden z autorów artykułu, Shaolei Ren z Uniwersytetu Kalifornijskiego w Riverside, stwierdził, że zjawisko to można przypisać sztucznej inteligencji. Zwłaszcza dużym inwestycjom w generatywną AI oraz współpracy OpenAI z gigantem z Redmond.

Autorzy szacunków powołują się wyłącznie na najpopularniejsze narzędzia AI. A trzeba mieć świadomość, że na świecie już teraz istnieją setki, jak nie tysiące firm, które korzystają z urządzeń wymagających chłodzenia. Mniejsze przedsiębiorstwa również muszą zapewnić optymalną temperaturę w swoich centrach obliczeniowych, co przekłada się na jeszcze większe zużycie chłodziwa, co nie jest brane pod uwagę w szacunkach badaczy.

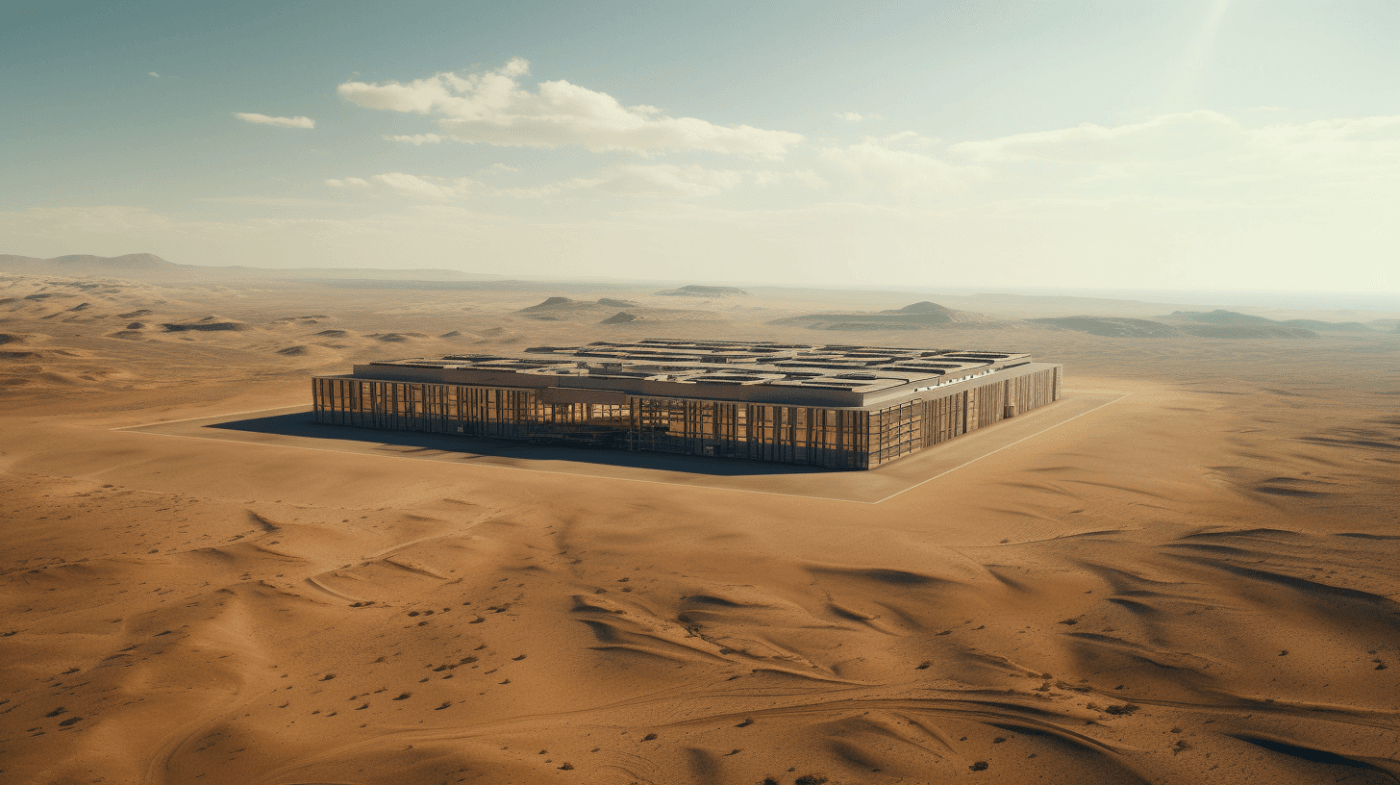

Jedną z możliwości jest przeniesienie centrów danych do chłodniejszych krajów lub… pod wodę. Regiony, które są naturalnie zimne, mogą być idealnymi miejscami zlokalizowania tam maszynerii generującej ciepło.

Firmą, która eksperymentowała z podwodnymi centrami danych, jest Microsoft. Jego przedstawiciele twierdzą, że jest to rozwiązanie niezawodne, praktyczne i zużywa mniej energii niż konwencjonalne sposoby obniżania temperatury maszyn. Przeniesienie centrów obliczeniowych pod wodę nie wydaje się jednak sensowne. Pracownicy Microsoftu nie wzięli pod uwagę, że instalacje te mogą ogrzewać wodę dookoła kapsuł z serwerami. Jeśli pozostałe przedsiębiorstwa pójdą tą samą drogą, to ocean może zacząć się ocieplać. A to nie pozostanie bez wpływu na przykład na klimat.

Być może rozwiązanie jest prostsze, niż by się mogło wydawać. Skoro centra danych generują duże ilości ciepła, to może trzeba je odzyskiwać i wytwarzać z niego energię? Z pewnością na świecie jest wiele miejsc, gdzie energii brakuje, więc może to tam trzeba przenieść aparaturę?

Źródła:

To może cię również zainteresować:

Dziękujemy, że przyczytałeś artykuł do końca. Jesli chcesz, możesz wesprzeć naszą pracę: