Prawda i Dobro

Ty decydujesz. Wspieraj edukację i kulturę swoim 1,5 proc. z PIT

09 marca 2026

Jak grom z jasnego nieba do opinii publicznej trafił list otwarty, opublikowany na stronie internetowej organizacji Future of Life Institute. Wśród sygnatariuszy znajdziemy przedstawicieli świata nauki i techniki z Elonem Muskiem, Stevem Wozniakiem i Yuvalem Hararim na czele. Czytamy w nim, że dla dobra ludzkości należy natychmiast wstrzymać prace nad rozwojem modeli AI wydajniejszych niż GPT-4.

Przekaz listu może szokować, zwłaszcza w obliczu zachwytów użytkowników nad możliwościami ChatuGPT – najpopularniejszego chatbota opartego na sztucznej inteligencji. Choć oddany w ręce mas dopiero w listopadzie 2022, zdaje już egzaminy na studia, pisze wiersze, programuje i szczegółowo odpowiada na nawet najbardziej abstrakcyjne pytania. Czy alarm naukowców jest uzasadniony i rozwój AI powinien zostać wstrzymany?

Wzywamy wszystkie laboratoria AI do natychmiastowego wstrzymania na co najmniej sześć miesięcy szkolenia systemów AI wydajniejszych niż GPT-4 (w tym obecnie szkolonego GPT-5).

– czytamy w liście Future of Life Institute.

W treści znajdziemy listę otwartych pytań dotyczących tego, jak wyobrażamy sobie współistnienie ze sztuczną inteligencją:

Trzeba przyznać, że tak postawione pytania wywołują mieszane uczucia. Głównie dlatego, że nie dotyczą fabuły dystopijnej powieści science-ficition, lecz chatbota, z którego skorzystać może każdy.

I nie chodzi (tym razem) o masową fascynację komunizmem. Tzw. red flag to potoczny termin określający zagrożenie. A tych w kontekście galopującego rozwoju sztucznej inteligencji nie brakuje.

Narzędzie o tak ogromnych możliwościach w zaledwie kilka miesięcy pokazało, że może stanowić strukturalne zagrożenie dla wielu kluczowych obszarów naszego życia. Zacznijmy od rynku pracy.

I tak np. copywriting, czyli pisanie na potrzeby szeroko pojętego internetu (marketing, sprzedaż, blogi) znalazł się w grupie ryzyka. ChatGPT w rękach wprawnej osoby jest w stanie z powodzeniem zastąpić kilkunastu, jeśli nie kilkudziesięciu copywriterów. Na pstryknięcie palca niemal cała profesja musi na wczoraj aktualizować wiedzę i adaptować się do zmian. W przeciwnym razie roboty wygrają konkurencję.

Przeczytaj koniecznie ten artykuł: USA ograniczają Polsce rozwój AI. Ekspertka PISM wyjaśnia powody

Jednak jeszcze większy problem pojawił się w edukacji. Coraz częściej słyszymy, że sztuczna inteligencja zdała egzaminy wstępne na ten czy inny uniwersytet. Jest w stanie na akceptowalnym poziomie pisać teksty akademickie. Stawia to przed nauczycielami szereg wyzwań. Będą musieli zwiększyć nadzór nad tekstami, używając narzędzi weryfikujących czy za treścią stoi człowiek, czy robot. Masowy dostęp uczniów do AI wzbudza protesty pedagogów i kolejne amerykańskie stany blokują możliwość używania go na szkolnym sprzęcie.

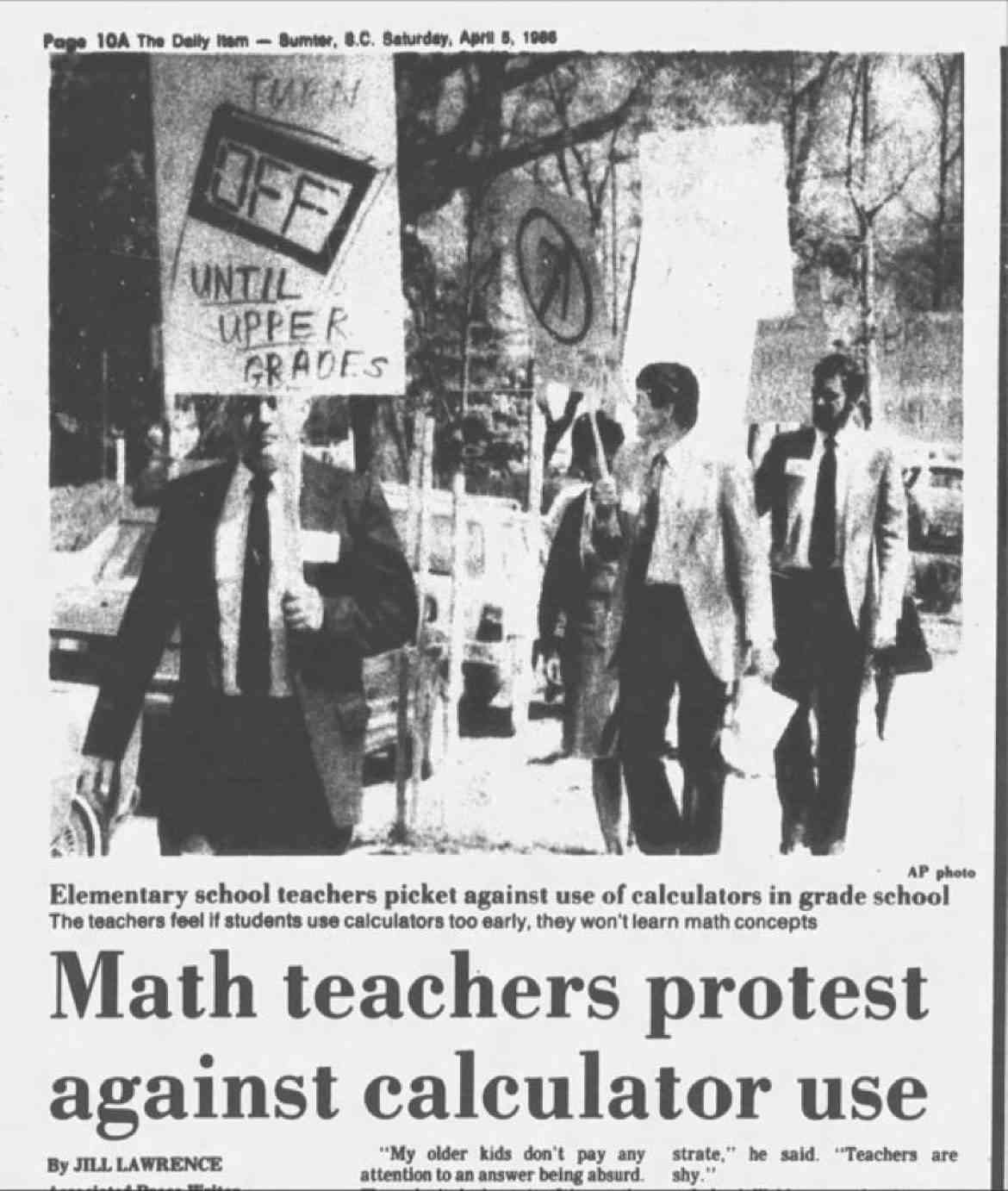

Podobnie jak teraz, 60 lat temu w USA nauczyciele protestowali przeciwko kalkulatorom. Millenialsi i starsze pokolenia zapewne pamiętają słowa matematyczek: ucz się liczyć, nie zawsze będziesz miał przy sobie kalkulator. Dzisiaj, ze smartfonem w ręce, to wspomnienie wywołuje jedynie uśmiech.

Znane nam dzisiaj zastosowania AI to tylko szczyt góry lodowej. Jaki jest jej rozmiar? Problem w tym, że nie mamy pojęcia! Stąd wezwanie naukowców do opamiętania.

Przeczytaj również: Kredyty węglowe jak kartki na mięso w PRL. Wszyscy zapłacimy za emisję CO2?

Wydaje się, że apel jest jak najbardziej uzasadniony. Skomentowała go na swoim profilu LinkedIn dr Dota Szymborska, filozofka i ekspertka ds. AI:

Etycznie rzecz biorąc, proponowana przerwa w rozwoju systemów AI potężniejszych niż GPT-4 może być uzasadniona, aby umożliwić naukowcom, inżynierom, politykom i społeczeństwu przemyślenie kierunku, w jakim zmierzają te technologie. Pauza umożliwia analizę potencjalnych konsekwencji, ryzyka utraty kontroli nad systemami AI oraz rozważenie wpływu na demokrację i przyszłość pracy.

Jakie są więc postulaty naukowców? Oddajmy głos autorom listu:

Równolegle twórcy AI muszą współpracować z decydentami w celu radykalnego przyspieszenia rozwoju solidnych systemów zarządzania AI. Powinny one obejmować co najmniej: nowe i sprawne organy regulacyjne zajmujące się AI; nadzór i śledzenie systemów AI o dużych możliwościach i dużych pulach mocy obliczeniowej; systemy potwierdzania i znak wodny, które pomogą odróżnić prawdziwe treści od syntetycznych i śledzić wycieki modeli; sprawny ekosystem audytu i certyfikacji; odpowiedzialność za szkody wyrządzone przez AI; solidne finansowanie publiczne badań nad bezpieczeństwem technicznym AI; oraz dobrze wyposażone instytucje, które poradzą sobie z dramatycznymi zakłóceniami gospodarczymi i politycznymi (zwłaszcza dla demokracji), jakie spowoduje AI.

Można by pomyśleć, że nie ma z czym polemizować. Tak zaawansowana technologia jest po prostu niebezpieczna. Niestety, logika i rozsądek mają potężnego wroga, któremu na imię chciwość.

Czy jest dziełem przypadku, że list otwarty trafił do sieci niemal w tym samym momencie, w którym ChatGPT został podłączony do internetu? Do niedawna bowiem w odpowiedzi na zadane pytanie chatbot analizował niewyobrażalną ilość danych. Nie potrafił jednak kupić biletu na samolot, wyszukać restauracji z najlepszymi ocenami w okolicy, czy zamówić taksówkę. Teraz właśnie zaczął się tego uczyć. Mówiąc najprościej na wydane polecenie ChatGPT używa innych aplikacji, aby wykonać powierzone zadanie.

Przeważy rozsądek i logika czy szaleńczy wyścig o palmę pierwszeństwa w rozwoju technologii, która fundamentalnie zmieni nasze życie? Czy tego chcemy, czy nie, odpowiedź poznamy w nieodległej przyszłości.

Dziękujemy, że przyczytałeś artykuł do końca. Jesli chcesz, możesz wesprzeć naszą pracę: